เคยเขียนบทความเรื่อง 3 เสาหลักของการสร้าง AI ขนาดใหญ่ ว่ามันเป็นเกมของยักษ์ เพราะ AI ขนาดใหญ่ต้องเกิดจาก data, compute, algorithm ประกอบเข้าด้วยกัน

คำว่า compute ในที่นี้ย่อมหมายถึง GPU หรือชิปเฉพาะทางอื่นๆ ตามที่เขียนไว้แล้ว

SemiAnalysis เว็บวิเคราะห์อุตสาหกรรมเซมิคอนดักเตอร์ที่ติดตามอยู่ ได้เขียนบทความเรื่องปริมาณ GPU ในวงการ AI ไว้น่าสนใจ

ตัวบทความฉบับเต็มต้องเสียเงินค่าสมาชิกเพื่ออ่าน แต่ช่วงแรกของบทความที่เปิดให้อ่านฟรีก็ค่อนข้างยาวประมาณหนึ่งแล้ว อ่านได้เนื้อหาใจความเยอะโดยไม่ต้องจ่ายเงิน

ประเด็นหลักที่ SemiAnalysis กล่าวถึงคือการจัดกลุ่มบริษัทที่มี GPU จำนวนมากหรือน้อย (ในที่นี้หมายถึง GPU ระดับศูนย์ข้อมูล NVIDIA A100/H100 ตัวละเป็นล้าน) ซึ่งกระทบต่อความสามารถในการเทรนโมเดลขนาดใหญ่อย่างมาก

GPU-Rich

กลุ่มที่มี GPU จำนวนเยอะ (ในที่นี้คือมากกว่า 20,000 ตัวต่อบริษัท)

- OpenAI (เข้าใจว่ารวม Microsoft)

- Anthropic

- Inflection

- X/Tesla

- Meta

อาจมีพวกบริษัทจีนบางรายที่มี GPU ระดับ 100,000 ตัวขึ้นไป แต่ข้อมูลฝั่งจีนมีน้อย

บริษัทกลุ่ม elite พวกนี้มีการรวมตัวกันเองในชื่อว่า Frontier Model Forum เพราะสามารถสร้างโมเดลขนาดใหญ่ที่ใช้บุกเบิกอนาคต (frontier) ได้

แม้แต่บริษัทใหญ่ระดับ Microsoft ก็ยังมีปัญหานี้ โดย Kevin Scott CTO ของ Microsoft เคยให้สัมภาษณ์เอาไว้ว่าเขาต้องดึงงบซื้อ GPU ของทั้งบริษัทมาถือไว้คนเดียว เพื่อจัดสรรทรัพยากรใหม่ให้เหมาะสม ซึ่งไม่ใช่เรื่องดีเพราะคนเกลียดเขาทั้งบริษัทเลย แต่เป็นสิ่งที่จำเป็นต้องทำ

แสดงให้เห็นว่าเรื่อง GPU มันบีบคั้นมาก แข่งขันสูงมาก (NVIDIA รวย!)

https://twitter.com/Podcast_GPT/status/1661743320425721860

GPU-Poor

ก็คือบริษัทสตาร์ตอัพเล็กๆ หรือนักวิจัยอิสระที่ไม่ได้อยู่ในกลุ่มแรก ข้อเสียเปรียบของกลุ่มนี้คือต่อให้คิดอัลกอริทึมหรือโมเดลที่ดีแค่ไหนก็ตาม แต่การไม่มีเครื่องมือ (GPU) ทำให้เทรนโมเดลขนาดใหญ่ได้ช้ากว่ากลุ่มแรกมาก

ทางออกของบริษัทหรือนักวิจัยกลุ่มนี้ จึงเป็นการนำโมเดลขนาดใหญ่ที่เป็นโอเพนซอร์ส (เช่น Meta Llama) มาปรับจูนอีกที หรือทำโครงการขนาดเล็กลง โมเดลแบบแน่นขึ้น (dense model vs sparse model) เพื่อให้ GPU เกรดทั่วไป เกรดเกมมิ่ง สามารถใช้แทนได้

อีกทางเลือกของบริษัทกลุ่มหลังคือการเช่า GPU ผ่านคลาวด์แทน ถ้าไม่ใช่กลุ่ม cloud provider ขนาดใหญ่ ตัวอย่างผู้ให้บริการรายย่อยคือ HuggingFace (pricing) แต่ตลาดนี้กำลังจะถูกทำลายเช่นกัน เพราะ NVIDIA จะลงมาทำแข่งภายใต้บริการชื่อ DGX Cloud ซึ่งเหนือกว่าทุกคนตรงที่มี GPU ของตัวเองกันไว้ใช้เองอยู่แล้ว

TPU

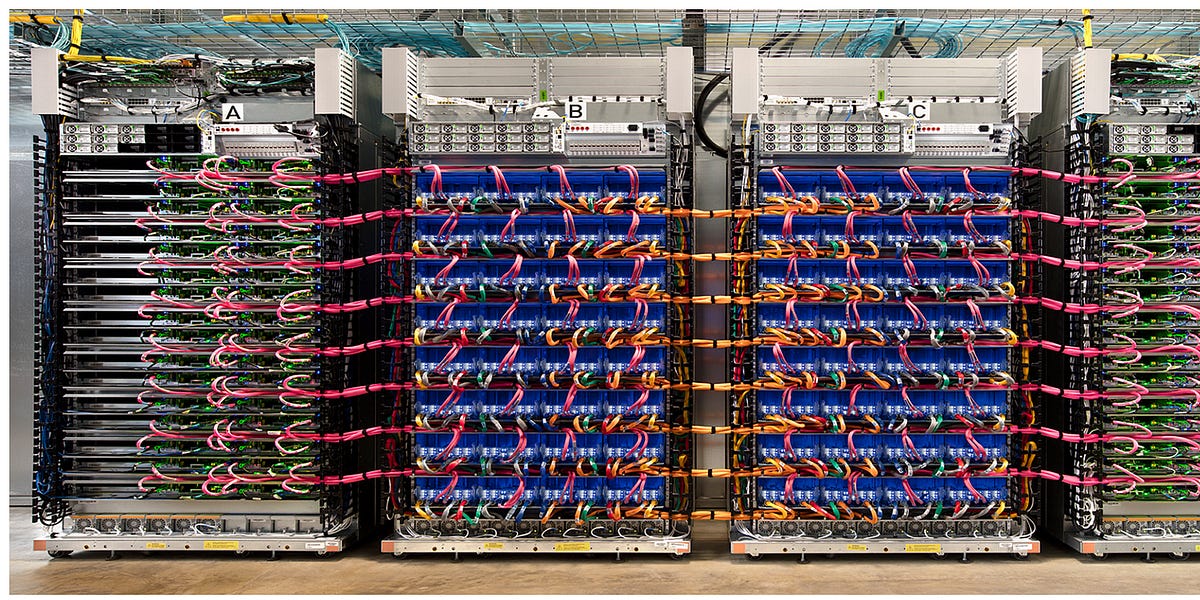

ทางออกอีกแบบไปเลยของวงการ GPU สำหรับเทรนโมเดล คือ การใช้ชิปแบบอื่นอย่าง TPU (Tensor Processing Unit) ซึ่งมี Google เพียงบริษัทเดียวที่มีอะไรแบบนี้

ผมเคยเขียนเรื่อง TPU เอาไว้บ้าง ความน่ากลัวที่สุดของ TPU คือการที่ Google รู้ปริมาณ workload ของตัวเองว่าโมเดลแบบไหนมีเยอะน้อย ขึ้นลงตามยุคสมัย

www.blognone.com

www.blognone.com จากตารางจะเห็นว่า งานบางประเภท เช่น Deep learning recommendation models (DLRM) ที่แนะนำสิ่งที่ผู้ใช้น่าจะชอบ (เช่น คลิปใน YouTube) เริ่มลดปริมาณลง แต่งานรันโมเดล Transformer ขนาดใหญ่ (LLM) เพิ่มขึ้นในช่วงหลัง

การที่ Google มองเห็นเทรนด์พวกนี้ จึงสามารถออกแบบ TPU ให้เหมาะสมตามปริมาณงานได้ (เช่น การมีฮาร์ดแวร์ SparseCore สำหรับงาน DLRM) ในแง่ efficiency ย่อมดีกว่าคู่แข่งรายอื่นๆ ที่ใช้ Generic GPU อยู่แล้ว (ข่าวล่าสุดเรื่อง TPU v5e ที่เน้น efficiency แบบสุดๆ) Google จึงได้เปรียบการแข่งขันเรื่องต้นทุนรวมในการเทรน-รันโมเดลอย่างมาก

ความน่ากลัวของการมี TPU เอง สามารถดูได้จากคลิปนี้ คู่แข่งดูแล้วก็ไม่รู้จะเอาอะไรไปสู้อีกเหมือนกัน

หลังบทความนี้เผยแพร่ออกไป Sam Altman ซีอีโอของ OpenAI ถึงกับโพสต์แซะว่า กูเกิลจ้าง SemiAnalysis มาเขียนโปรโมทเลยเหรอ

incredible google got that semianalysis guy to publish their internal marketing/recruiting chart lol

— Sam Altman (@sama) August 29, 2023