มีโอกาสได้อ่านโพสต์ของ Richard Sutton นักวิจัยด้าน AI ชื่อดังจากแคนาดา หนึ่งในผู้บุกเบิกเทคนิค reinforcement learning (RL) ยุคหลังๆ ซึ่งกลายมาเป็นแกนหลักสำคัญของ AI ที่แบบเรียนรู้ด้วยตัวเองยุคใหม่ๆ อย่าง AlphaGo และ AlphaZero ด้วย

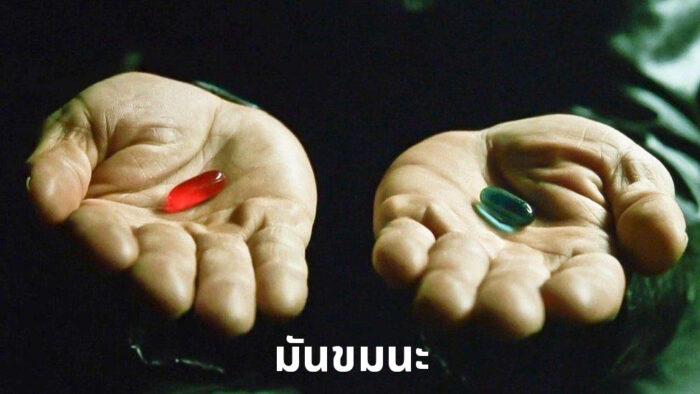

โพสต์ของ Sutton เขียนในปี 2019 ชื่อว่า “บทเรียนอันขมขื่น” (The Bitter Lesson) ถือเป็น “ข้อสังเกต” (observation) ของเขาที่กลายมาเป็นหลักการสำคัญของวงการ AI อย่างน้อยก็ของกลุ่มคนที่เชื่อมั่นในแนวทาง RL ว่าคือเส้นทางที่มุ่งไปสู่ AGI ในอนาคต

Sutton บอกว่าวงการ AI มีอายุประมาณ 70 ปี นับตั้งแต่ยุคเริ่มต้นมาจนถึงวันนี้ จะเห็นว่าแนวทางสร้าง AI แบบทั่วไป (general methods) จะสามารถเอาชนะวิธีการสร้างโมเดลเฉพาะทาง (special methods) ได้เสมอ

การสร้าง AI ทำงานหัวข้อใดๆ เป็นเรื่องยาก วิธีการของนักวิจัยในแต่ละยุคจึงเป็นการนำความรู้ของมนุษย์ (human knowledge) มาจำลองไว้ใน AI ด้วยวิธีการต่างๆ ซึ่งมักได้ผลในช่วงแรกๆ แต่สุดท้ายแล้วจะแพ้วิธีการสร้าง AI ที่ทำงานได้ทั่วไป ที่เทรนขึ้นมาโดยอาศัยแค่พลังประมวลผลล้วนๆ ไม่ต้องมีกรรมวิธีพิเศษใดๆ มาแทรกแซง

เหตุผลเป็นเพราะ AI แบบทั่วไปที่อาศัยวิธีการถึกๆ อย่าง search/learning algorithm ที่ดูธรรมดาทั่วไป มันจะเก่งขึ้นเรื่อยๆ ตามพลังประมวลผลที่เพิ่มขึ้นตามกาลเวลา (Sutton อ้างอิงจาก Moore’s law) ทำให้ท้ายที่สุดแล้ว โมเดลทั่วไปจะสามารถเอาชนะโมเดลเฉพาะกิจได้

Sutton ยกตัวอย่างในอดีตหลายเคส

- หมากรุก: อัลกอริทึมที่เอาชนะ Gary Kasparov ได้ในปี 1997 อาศัยแค่ deep search โดยที่ตัวโมเดลไม่ต้องรู้จักกลไกของหมากรุกพิเศษ แต่ชนะได้เพราะคอมแรงมากพอ

- โกะ: แบบเดียวกับหมากรุกเลย แต่มาช้ากว่ากัน 20 ปี เพราะโกะซับซ้อนกว่า ต้องรอนานกว่าคอมพิวเตอร์มีพลังประมวลผลมากพอ

- Speech Recognition: โมเดลที่อิงจากสถิติคำล้วนๆ (ใช้พลังประมวลผลเยอะกว่า) เอาชนะโมเดลที่มีโครงสร้างภาษาแบบมนุษย์ได้

- Computer Vision: โมเดลยุคหลังใช้แค่ convolution network ล้วนๆ ก็เอาชนะโมเดลในอดีตได้

[Sutton ไม่ได้เขียนถึงเพราะมันมาทีหลัง แต่กรณีของ LLM ที่เป็น transformer-based มีกลไก attention mechanism ที่เป็น generalization ใช้กับข้อมูลประเภทใดๆ ก็ได้ ก็เข้าข่าย The Bitter Lesson เหมือนกัน เทียบกับโมเดลภาษายุคก่อน]

Sutton เรียกปรากฏการณ์นี้ว่าเป็น “บทเรียนอันขมขื่นของนักวิจัย” ว่าวิธีเฉพาะทางมันไม่เวิร์คในระยะยาว การฝังความรู้ของมนุษย์ลงไปในโมเดลเป็นการเฉพาะทำงานได้ดีแค่ในระยะสั้น แต่ผ่านไปสักพักมันจะติดเพดาน แล้วจะมีโมเดลที่ breakthrough จากแนวทางที่อิงพลัง scaling ของการประมวลผลเกิดขึ้นมาเสมอ

ในปี 2025 Sutton ไปออกรายการของ Dwarkesh Patel และพูดเรื่องนี้ โดยใช้กรอบเรื่อง The Bitter Lesson มาวิจารณ์โมเดล LLM ในปัจจุบัน (ซึ่งมีความเป็น RL ในระดับนึงแล้ว) ว่ามันยังไม่ RL มากพอ

และมี บล็อกของ Andrej Karpathy ที่เขียนถกถึงเรื่องนี้ต่อ ซึ่งจะเขียนถึงในโอกาสถัดไป